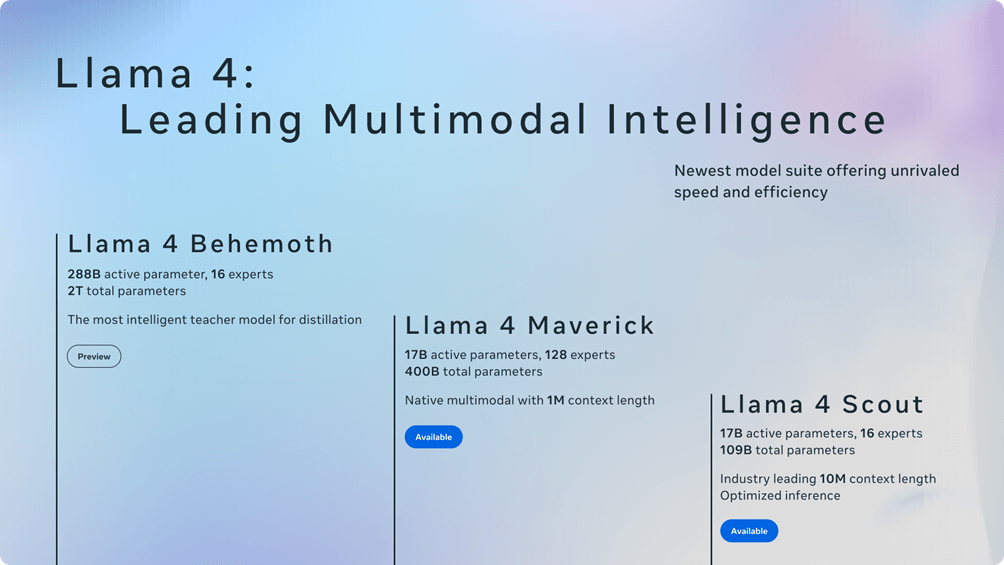

Meta ha ufficialmente presentato i primi modelli della serie Llama 4, segnando un passo significativo nel campo dell’intelligenza artificiale. I nuovi modelli, Llama 4 Scout e Llama 4 Maverick, promettono di offrire esperienze personalizzate e prestazioni elevate. Queste innovazioni si rivolgono a sviluppatori, aziende e utenti finali, aprendo la strada a nuove applicazioni in vari settori.

Llama 4 Scout: efficienza con una sola GPU

Llama 4 Scout è progettato con un’architettura compatta che consente di eseguire il modello su una singola GPU NVIDIA H100. Con i suoi 17 miliardi di parametri attivi e la presenza di 16 esperti, Scout si propone come uno dei migliori modelli multimodali disponibili sul mercato. La sua finestra di contesto da ben dieci milioni di token lo posiziona al vertice delle classifiche rispetto ad altri concorrenti come Gemma 3 e Mistral 3.1.

La capacità del modello di gestire un numero così elevato di token rappresenta un vantaggio notevole per le applicazioni che richiedono analisi approfondite o interazioni complesse. I benchmark riconosciuti evidenziano come Scout superi le performance dei suoi predecessori in vari ambiti d’uso.

Inoltre, la struttura del modello permette agli sviluppatori di integrare facilmente questa tecnologia nelle loro soluzioni senza necessità di hardware particolarmente costoso o complesso da gestire. Questo aspetto rende il modello accessibile anche a piccole imprese o startup che desiderano sfruttare l’intelligenza artificiale per migliorare i propri servizi.

Llama 4 Maverick: prestazioni elevate a costi contenuti

Accanto al modello Scout, Meta ha introdotto anche il Llama 4 Maverick, anch’esso dotato di ben diciassette miliardi di parametri attivi ma con una configurazione diversa che include fino a centoventotto esperti. Questa caratteristica consente a Maverick non solo prestazioni superiori ma anche un ottimo rapporto qualità-prezzo rispetto ad altre soluzioni presenti sul mercato come GPT-4o.

Con una valutazione ELO pari a 1417 su piattaforme dedicate ai benchmark AI come LMArena, Maverick emerge come scelta ideale per applicativi legati alla chat e all’assistenza virtuale. Le sue capacità nella comprensione multimodale lo rendono versatile in diversi scenari d’uso quotidiani dove è richiesta interazione tra testo e immagini.

Questa combinazione tra potenza computazionale ed economicità rappresenta un fattore chiave nel panorama competitivo dell’intelligenza artificiale moderna; molte aziende potrebbero trovare in questo modello la soluzione perfetta per soddisfare le proprie esigenze senza compromettere budget significativi.

Behemoth: il gigante da due trilioni

Meta sta lavorando anche su Behemoth, un progetto ambizioso destinato ad ampliare ulteriormente le possibilità offerte dalla serie Llama. Con ben duecentottantotto miliardi di parametri attivi previsti – quasi duemila miliardi totali – Behemoth promette prestazioni superiori rispetto ai già noti GPT-4.5 e Claude Sonnet3.7 nei benchmark STEM.

Sebbene non sia ancora completato, questo colosso dell’intelligenza artificiale potrebbe diventare fondamentale nell’ambito della formazione dei futuri modelli della serie Llama grazie alla sua architettura avanzata ed alle sue capacità elaborative straordinarie.

Il lavoro su Behemoth richiede risorse considerevoli sia dal punto di vista hardware che software; tuttavia, Meta sembra pronta ad affrontare questa sfida attraverso investimenti mirati nella propria infrastruttura tecnologica dedicata all’apprendimento automatico su larga scala.

Architettura innovativa per intelligenze artificiali più performanti

Una delle novità principali introdotte con la serie Llama è l’architettura “Mixture of Experts” , concepita per migliorare l’efficienza durante addestramento ed inferenza attivando solo alcuni parametri specifici per ogni token elaborato dal sistema AI.

Questa strategia permette ai modelli non solo d’essere più rapidi ma anche più economici nell’utilizzo delle risorse computazionali richieste durante il funzionamento quotidiano; ciò si traduce in minori costi operativi sia per gli sviluppatori sia per gli utenti finali.

In aggiunta alla MoE viene utilizzata una tecnica chiamata MetaP che automatizza impostazioni cruciali quali learning rate specifico dei layer coinvolti nel processo decisionale del sistema AI stesso; questo approccio garantisce maggiore adattabilità alle diverse lingue supportate dai nuovi modelli.

Ad esempio, LamaMaverick presenta diciassette miliardi d’parametri attivi insieme a quattrocento miliardi totali integrando strati misti d’esperti affinché ogni token venga instradato verso uno degli esperti disponibili mentre mantiene sempre accessibile quello condiviso fra tutti quanti loro.

Questo metodo migliora notevolmente l’efficienza operativa riducendo latenza nei servizi offerti dagli stessi sistemi intelligenti impiegati nelle varie applicazioni che possono beneficiare delle performance elevate garantite dai nuovi prodotti firmati Meta.

Post-training: ottimizzazione continua

Il post-training rappresenta uno degli aspetti cruciali per garantire successo duraturo ai nuovi modelli. L’intervento avviene attraverso pipeline leggere basate principalmente sul fine-tuning supervisionato integrandosi perfettamente col reinforcement learning online unitamente all’ottimizzazione preferenziale continua.

Grazie all’impiego dinamico del filtraggio prompt assicurato dal continuo adattamento, le abilità logiche, rappresentative e codifiche sono state sensibilmente potenziate portando così risultati tangibili negli ambiti richiesti dalle moderne esigenze aziendali.

La gestione proattiva dei bias politici e sociali supporta ulteriormente quest’approccio consentendo risposte più equilibrate rispetto generazioni precedenti; ciò dimostra chiaramente quanto impegno abbia messo Meta nello sviluppo responsabile della propria tecnologia.

Sicurezza avanzata contro rischi emergenti

Meta ha implementato misure innovative destinate alla mitigazione dei rischi in tutte le fasi dello sviluppo relativi ai propri prodotti. L’utilizzo di strumenti specializzati quali Lama Guarded Prompt Guard è stato pensato non soltanto per proteggere input/output ma anche per delimitare l’impatto negativo derivante dall’interazione umana diretta coi sistemi intelligenti.

Inoltre, l’integrazione CyberSecEval permette valutazioni riguardanti sicurezza informatica assicurandosi così che ogni progetto rimanga conforme agli standard richiesti evitando problematiche future legate a vulnerabilità sistemiche.

Tutte queste iniziative confermano quanto importante considerino queste sfide gli ingegneri della compagnia, impegnandosi continuamente affinché l’equilibrio sociale venga rispettato su piattaforme digitali sviluppate da essi stessi.

Sfide future nell’addestramento su larga scala

Per realizzare Behemoth è stata necessaria un’importante revisione strutturale riguardante infrastrutture dedicate all’apprendimento rinforzato sfruttando tecnologie asincrone capaci di aumentare significativamente l’efficacia generale raggiungendo incrementi del dieci volte rispetto generazioni comprese precedentemente prodotte.

Questo cambiamento radicale offre opportunità mai viste prima permettendo di scalabilità senza precedenti in termini quantitativi e qualitativi per tutti coloro che vorranno intraprendere percorsi formativi innovativi sull’intelligenza locale globale.